5 Mô hình ngôn ngữ lớn (LLM – Large Language Model) mã nguồn mở tốt nhất cho năm 2025

Trong bài viết sau đấy, chúng ta sẽ cùng khám phá 11 mô hình ngôn ngữ lớn (LLM) mã nguồn mở hàng đầu này và xây dựng các quy trình AI tiên tiến với tích hợp n8n và LangChain. Có nhiều cái tên chỉ mới lọt vào danh sách năm 2024 đã có chỗ đứng cao trong cộng đồng N8n.

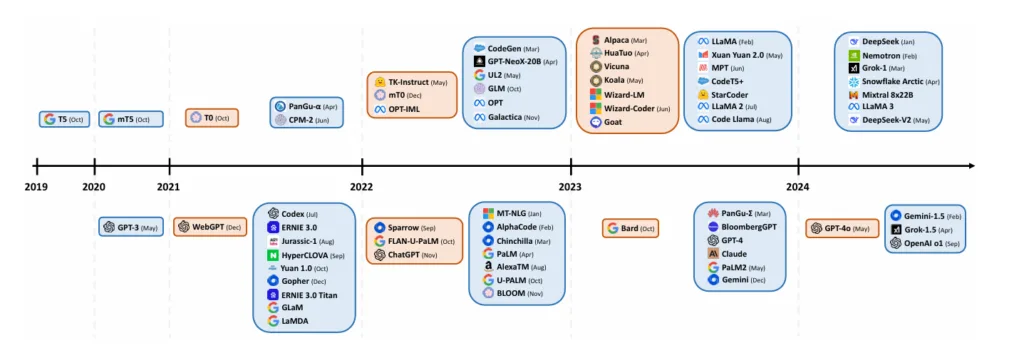

Các mô hình mã nguồn mở đang thay đổi cục diện của LLM, hứa hẹn mang lại khả năng bảo mật tốt hơn, tiết kiệm chi phí và dễ dàng tùy biến hơn cho các triển khai AI. Trong khi ChatGPT có hơn 180 triệu người dùng, các giải pháp triển khai tại chỗ (on-premises) đã chiếm hơn một nửa thị phần của LLM, và dự báo sẽ tiếp tục tăng trưởng trong những năm tới.

Xu hướng này rất rõ ràng: kể từ đầu năm 2023, số lượng mô hình mã nguồn mở được phát hành gần như đã gấp đôi so với các mô hình mã nguồn đóng.

Hôm nay, chúng ta sẽ cùng khám phá thế giới của các mô hình ngôn ngữ lớn (LLM) mã nguồn mở và:

- tìm hiểu lý do đằng sau làn sóng triển khai LLM mã nguồn mở ngày càng gia tăng;

- nhận diện những rủi ro và thách thức tiềm ẩn;

- điểm qua 11 mô hình LLM mã nguồn mở tốt nhất hiện nay;

- hướng dẫn bạn cách dễ dàng truy cập các mô hình AI mã nguồn mở mạnh mẽ này;

- chỉ dẫn bạn cách bắt đầu sử dụng LLM mã nguồn mở với Ollama và LangChain trong n8n.

👉 Hãy tiếp tục đọc để khám phá chi tiết!

Có mô hình LLM mã nguồn mở nào không?

Trong bài viết này, chúng tôi đã chọn lọc 11 mô hình LLM mã nguồn mở phổ biến, tập trung vào các mô hình được sử dụng rộng rãi và có sẵn trên Ollama.

Bài đánh giá của chúng tôi bao gồm cả các mô hình “base” đã được huấn luyện sẵn và các biến thể đã được tinh chỉnh. Những mô hình này có nhiều kích thước khác nhau, bạn có thể sử dụng trực tiếp hoặc chọn các phiên bản đã được tinh chỉnh từ nhà phát triển gốc hoặc từ các bên thứ ba.

Mặc dù các mô hình đã được huấn luyện sẵn cung cấp một nền tảng vững chắc, nhưng các phiên bản đã tinh chỉnh thường cần thiết cho các ứng dụng thực tế và chuyên biệt theo từng tác vụ. Nhiều nhà cung cấp đã cung cấp sẵn các mô hình được tinh chỉnh trước, tuy nhiên người dùng cũng có thể tạo bộ dữ liệu riêng để tinh chỉnh thêm, phục vụ cho các trường hợp sử dụng đặc thù hơn.

Dưới đây là bảng xếp hạng các mô hình ngôn ngữ lớn mã nguồn mở (LLM) mà bạn nên biết:

Bảng xếp hạng LLM mã nguồn mở

| Mô hình | Nhà phát triển | Thông số | Cửa sổ ngữ cảnh | Ứng dụng phổ biến | Giấy phép |

|---|---|---|---|---|---|

| Llama 3 | Meta | 1B, 3B, 8B, 70B, 405B | 8k, 128k | – Sinh văn bản tổng quát – Nhiệm vụ đa ngôn ngữ – Sinh mã – Nội dung dạng dài – Tinh chỉnh cho lĩnh vực cụ thể | Llama Community License |

| Mistral | Mistral AI | 3B – 124B | 32k – 128k | – Nhiệm vụ phức tạp – Xử lý đa ngôn ngữ – Sinh mã – Hiểu hình ảnh – AI chạy trên thiết bị – Gọi hàm – Xử lý quy mô lớn hiệu quả | Apache 2.0, Mistral Research License, Commercial License |

| Falcon 3 | TII | 1B, 3B, 7B, 10B | 8k – 32k | – Sinh văn bản – Sinh mã – Bài toán toán học – Tri thức khoa học – Ứng dụng đa ngôn ngữ – Tinh chỉnh lĩnh vực cụ thể | TII Falcon License |

| Gemma 2 | 2B, 9B, 27B | 8k | – Sinh văn bản – Trả lời câu hỏi – Tóm tắt – Sinh mã – Tinh chỉnh cho lĩnh vực cụ thể | Gemma License | |

| Phi-3.x / 4 | Microsoft | 3.8B (mini), 7B (small), 14B (medium), 42B (MoE) | 4k, 8k, 16k, 128k | – Sinh văn bản – Tác vụ đa ngôn ngữ – Hiểu mã – Lý luận toán học – Hiểu hình ảnh (mô hình thị giác) – Suy luận tại chỗ (on-device) | Microsoft Research License |

| Command R | Cohere | 7B, 35B, 104B | 128k | – AI hội thoại – Truy xuất kiến thức (RAG) – Sử dụng công cụ – Tác vụ đa ngôn ngữ – Nội dung dạng dài | CC-BY-NC 4.0 |

| StableLM 2 | Stability AI | 1.6B, 3B, 12B | Lên đến 16k | – Sinh văn bản đa ngôn ngữ – Sinh và hiểu mã – Tinh chỉnh tác vụ cụ thể – Nghiên cứu và thương mại | Stability AI Community và Enterprise License |

| StarCoder2 | BigCode | 3B, 7B, 15B | 16k | – Hoàn thành mã – Hỗ trợ nhiều ngôn ngữ lập trình – Hiểu mã – Tinh chỉnh theo tác vụ | Apache 2.0 |

| Yi | 01.AI | 6B, 9B, 34B | 4k, 8k, 200k | – Sinh văn bản song ngữ – Hiểu và sinh mã – Nhiệm vụ toán học, lý luận – Tinh chỉnh theo lĩnh vực | Apache 2.0 |

| Qwen2.5 | Alibaba | 0.5B – 72B | 128k | – Sinh văn bản tổng quát – Tác vụ đa ngôn ngữ – Sinh mã – Lý luận toán học – Xử lý dữ liệu có cấu trúc | Qwen License (cho bản 3B và 72B), Apache 2.0 (cho các bản khác) |

| DeepSeek-V2.x / V3 | DeepSeek AI | 16B, 236B, 671B (V3) – đã kích hoạt 2.4B – 37B | 32k – 128k | – Sinh văn bản – Tác vụ đa ngôn ngữ – Sinh mã – Tinh chỉnh – Lý luận nâng cao (V3) | DeepSeek License |

Tài nguyên thêm

Nếu bạn muốn khám phá thêm các mô hình LLM mã nguồn mở, hãy tham khảo Awesome-LLM GitHub repository, nơi có danh sách đầy đủ các mô hình ngôn ngữ và tài nguyên liên quan.

Ưu điểm và nhược điểm của các mô hình LLM mã nguồn mở

Ưu điểm:

- Quyền sở hữu đầy đủ: Đảm bảo kiểm soát hoàn toàn đối với mô hình, dữ liệu huấn luyện bổ sung và ứng dụng thực tế.

- Tăng độ chính xác tinh chỉnh: Tinh chỉnh chính xác hơn nhờ vào khả năng tùy chỉnh linh hoạt các tham số mô hình địa phương, được cộng đồng hỗ trợ.

- Tuổi thọ dài lâu: Các mô hình tự lưu trữ sẽ không bị lỗi thời, không giống như các nhà cung cấp mô hình đóng, có thể “nghỉ hưu” các mô hình cũ.

- Ước tính chi phí tốt hơn: Chi phí dịch chuyển từ mô hình tính phí theo mức sử dụng có thể thay đổi sang chi phí cơ sở hạ tầng ổn định hơn. Tuy nhiên, tổng chi phí có thể cao hơn so với các dịch vụ dựa trên đăng ký, tùy thuộc vào thói quen sử dụng và lựa chọn cơ sở hạ tầng.

- Linh hoạt trong việc chọn phần mềm và phần cứng: Cho phép phân bổ tài nguyên tối ưu dựa trên nhu cầu cụ thể.

- Cộng đồng đóng góp: Cộng đồng giúp tối ưu hóa mô hình thông qua các kỹ thuật như quantization (nén mô hình) và pruning (rút gọn mô hình), cũng như phát triển các chiến lược triển khai hiệu quả và công cụ hỗ trợ.

Nhược điểm:

Chất lượng không đồng đều: Các mô hình mã nguồn mở có thể không đạt được chất lượng cao như các giải pháp được cung cấp bởi các tập đoàn lớn, do hạn chế tài nguyên.

Rủi ro bị tấn công: Môi trường mã nguồn mở có thể dễ bị lợi dụng, nơi các tác nhân xấu có thể thao túng dữ liệu đầu vào và can thiệp vào hành vi của mô hình.

Yêu cầu giấy phép phức tạp: Giấy phép sử dụng có sự khác biệt lớn:

- Một số mô hình sử dụng giấy phép tự do (như Apache 2.0),

- Một số mô hình có hạn chế phi thương mại,

- Một số mô hình (như Meta Llama 3) có các điều khoản riêng biệt cho việc sử dụng thương mại.

Mô hình LLM mã nguồn mở tốt nhất là gì?

Không có mô hình LLM mã nguồn mở nào là tốt nhất duy nhất.

Và đây là lý do tại sao.

Có nhiều chỉ số để đánh giá các mô hình, và các nhóm nghiên cứu khác nhau quyết định chỉ số nào là phù hợp. Điều này khiến việc so sánh khách quan trở nên khá khó khăn.

Nhờ vào Hugging Face, hiện có một bảng xếp hạng công khai cho các mô hình LLM mã nguồn mở.

Bảng xếp hạng thực hiện các bài kiểm tra trên 6 chỉ số quan trọng sử dụng Eleuther AI Language Model Evaluation Harness. Các kết quả được tổng hợp và mỗi mô hình nhận được một điểm số cuối cùng.

Bảng xếp hạng có một số bộ lọc nhanh cho các mô hình dành cho người tiêu dùng, thiết bị biên, v.v. Cũng có sẵn một số cột điều chỉnh như kích thước mô hình, phương pháp lượng tử hóa, v.v.

Bảng xếp hạng là một cuộc thi mở và bất kỳ ai cũng có thể gửi mô hình của mình để được đánh giá.

Hãy cùng xem từng mô hình LLM mã nguồn mở một và tìm hiểu kỹ hơn về chúng!

Top 5 LLM nguồn mở năm 2025

Danh sách được chúng tôi xếp hạng theo nhiều tiêu chí đánh giá khách quan. Để biết cách tích hợp chúng vào N8n, các bạn hãy truy cập vào kho template của chúng tôi tại đây

1. Llama3

Llama3 rất phù hợp cho các ứng dụng đa mục đích với nhu cầu mở rộng.

Llama 3 là thế hệ mới nhất của các mô hình ngôn ngữ lớn mã nguồn mở từ Meta, cung cấp hiệu suất cao trên một loạt các nhiệm vụ. Mô hình Llama 3.3 70B mới nhất mang lại hiệu suất tương đương với mô hình 405B tham số nhưng với chi phí tính toán thấp hơn rất nhiều, khiến nó trở thành một lựa chọn hấp dẫn cho các nhà phát triển và nhà nghiên cứu.

Các tính năng chính của Llama 3

- Nhiều kích thước mô hình: 1B, 3B, 8B, 70B và 405B tham số

- Khả năng đa ngôn ngữ và đa phương thức

- Nhóm truy vấn chú ý (GQA) để cải thiện hiệu quả suy luận

- Cửa sổ ngữ cảnh 8k token cho các mô hình nhỏ, lên đến 128k token cho các mô hình lớn hơn

- Phát triển AI có trách nhiệm với các công cụ như Llama Guard 2 và Code Shield

Các trường hợp sử dụng của Llama 3

- Tạo và hiểu văn bản đa mục đích

- Ứng dụng đa ngôn ngữ trên nhiều ngôn ngữ khác nhau

- Tạo và hiểu mã

- Tạo và phân tích nội dung dài

- Fine-tuning cho các lĩnh vực hoặc nhiệm vụ cụ thể

- Tương tác như trợ lý trong các chatbot và ứng dụng AI

2. Mistral

Tốt nhất cho: AI trên thiết bị với gọi hàm

Mistral AI, một startup của Pháp, đã nhanh chóng trở thành một đối thủ lớn trong không gian LLM mã nguồn mở. Các mô hình của Mistral được thiết kế để phục vụ cho nhiều ứng dụng, từ thiết bị biên (edge devices) đến các giải pháp doanh nghiệp quy mô lớn. Công ty cung cấp cả các mô hình mã nguồn mở dưới giấy phép Apache 2.0 và các mô hình thương mại với giấy phép có thể đàm phán.

Mô hình Mistral mới nhất (3B và 8B) đặc biệt đáng chú ý với hiệu suất vượt trội trong các tình huống tính toán biên, vượt trội so với các mô hình cùng kích thước từ các ông lớn công nghệ.

Các tính năng chính của Mistral AI

- Nhiều kích thước mô hình: từ 3B đến 124B tham số

- Khả năng đa ngôn ngữ và đa phương thức

- Cửa sổ ngữ cảnh lớn lên đến 128k token

- Hỗ trợ gọi hàm bản địa

- Kiến trúc Mixture-of-Experts (MoE) trong một số mô hình

- Các mô hình hiệu quả cho tính toán biên và AI trên thiết bị

- Khả năng fine-tuning cho các lĩnh vực hoặc nhiệm vụ cụ thể

Các trường hợp sử dụng của Mistral AI

- Tạo và hiểu văn bản đa mục đích

- Lý luận và giải quyết vấn đề với độ phức tạp cao

- Tạo và hiểu mã

- Phân tích hình ảnh và các nhiệm vụ đa phương thức

- AI trên thiết bị cho smartphone và laptop

- Xử lý quy mô lớn hiệu quả với các mô hình MoE

3. Falcon 3

Tốt nhất cho: Các môi trường chạy mà trong đó tài nguyên tính toán bị hạn chế

Falcon 3 là phiên bản mới nhất của các mô hình ngôn ngữ lớn mã nguồn mở được phát triển bởi Viện Đổi mới Công nghệ (TII) ở Abu Dhabi. Dòng mô hình này thể hiện hiệu suất ấn tượng đối với các LLM nhỏ, đồng thời giúp phổ biến quyền truy cập vào AI tiên tiến bằng cách cho phép vận hành hiệu quả trên các hạ tầng nhẹ, bao gồm cả laptop.

Các tính năng chính của Falcon 3

- Nhiều kích thước mô hình: 1B, 3B, 7B và 10B tham số

- Được huấn luyện trên 14 nghìn tỷ token, gấp đôi so với phiên bản trước

- Khả năng lý luận vượt trội và khả năng fine-tuning nâng cao

- Cửa sổ ngữ cảnh mở rộng lên tới 32k token (trừ mô hình 1B với 8k)

- Hỗ trợ đa ngôn ngữ (Tiếng Anh, Pháp, Tây Ban Nha và Bồ Đào Nha)

- Biến thể Falcon3-Mamba-7B sử dụng kiến trúc State Space Model (SSM) thay thế

Các trường hợp sử dụng của Falcon 3

- Tạo và hiểu văn bản đa mục đích

- Tạo và hiểu mã

- Các nhiệm vụ toán học và khoa học

- Ứng dụng đa ngôn ngữ

- Fine-tuning cho các lĩnh vực hoặc nhiệm vụ cụ thể

- Triển khai hiệu quả trong các môi trường tài nguyên hạn chế

4. Gemma 2

Tốt nhất cho: Việc phát triển và triển khai các ứng dụng AI

Gemma 2 là dòng mô hình ngôn ngữ lớn mã nguồn mở mới nhất của Google, được xây dựng dựa trên cùng nghiên cứu và công nghệ sử dụng để tạo ra các mô hình Gemini. Cung cấp hiệu suất mạnh mẽ cho kích thước của nó, Gemma 2 được thiết kế với trọng tâm vào phát triển AI có trách nhiệm và triển khai hiệu quả.

Các tính năng chính của Gemma 2

- Nhiều kích thước mô hình: 2B, 9B, và 27B tham số

- Hiệu suất xuất sắc, với mô hình 27B vượt trội so với một số mô hình sở hữu lớn hơn

- Tối ưu hóa cho suy luận hiệu quả trên các phần cứng khác nhau, từ thiết bị biên đến triển khai đám mây

- Các cải tiến an toàn tích hợp và các thực tiễn AI có trách nhiệm

- Tương thích với nhiều framework (Keras, JAX, PyTorch, Hugging Face, v.v.)

- Công cụ bổ trợ: ShieldGemma cho an toàn nội dung và Gemma Scope cho khả năng giải thích mô hình

Các trường hợp sử dụng của Gemma 2

- Tạo và hiểu văn bản đa mục đích

- Trả lời câu hỏi và tóm tắt

- Tạo và hiểu mã

- Fine-tuning cho các lĩnh vực hoặc nhiệm vụ cụ thể

- Nghiên cứu và phát triển AI có trách nhiệm

- Ứng dụng AI trên thiết bị (đặc biệt với mô hình 2B)

5.Deepseek 2.x / 3

Tốt nhất cho: Xử lý ngôn ngữ quy mô lớn, với số lượng tham số ấn tượng 671B nhưng lại chia ra hệ thống chuyên gia giúp giảm tỷ lệ halluciation đáng kể do tràn tham số, chính nhờ vậy giúp cho deepseek có giá trị cao mà chi phí training khá rẻ.

DeepSeek là một loạt các mô hình LLM mã nguồn mở mạnh mẽ được phát triển bởi DeepSeek AI, với các kiến trúc sáng tạo nhằm tối ưu hóa suy luận và đào tạo tiết kiệm chi phí. Các mô hình DeepSeek-V2 và V2.5 có sẵn để sử dụng với Ollama. Trong khi đó, DeepSeek-V3 vừa được phát hành gần đây với khả năng ấn tượng hơn với 671B tham số, nhưng hiện tại vẫn chưa có sẵn trong Ollama tại thời điểm viết.

Các tính năng chính của DeepSeek

- Kiến trúc Mixture-of-Experts (MoE) giúp sử dụng tham số hiệu quả

- Multi-head Latent Attention (MLA) cải thiện hiệu suất suy luận

- Cửa sổ ngữ cảnh lớn lên đến 128k token

- Khả năng đa ngôn ngữ, với hiệu suất mạnh mẽ trong tiếng Anh và tiếng Trung

- Tối ưu hóa cho cả tạo văn bản chung và các tác vụ mã hóa

Các trường hợp sử dụng của DeepSeek

- Tạo và hiểu văn bản đa mục đích

- Ứng dụng đa ngôn ngữ và dịch thuật

- Tạo và hiểu mã

- Fine-tuning cho các lĩnh vực hoặc nhiệm vụ cụ thể

- Tương tác giống như trợ lý trong các chatbot và ứng dụng AI

- Tạo và phân tích nội dung dài

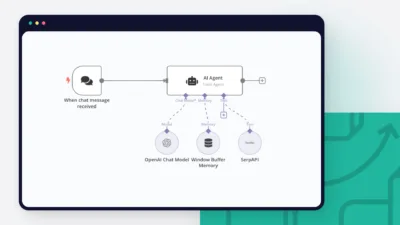

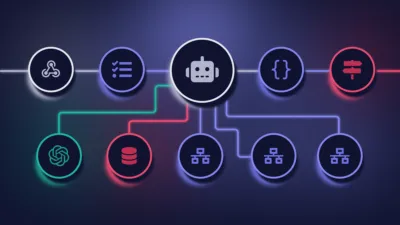

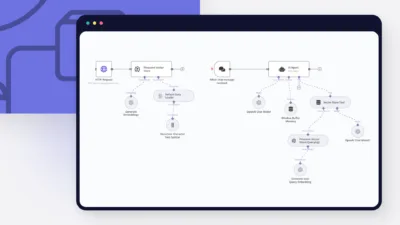

Ứng dụng các LLM vào N8n

Nếu việc chạy một LLM mã nguồn mở có vẻ quá phức tạp, chúng tôi có tin vui: trong n8n, bạn có thể bắt đầu nhanh chóng với Ollama. Tích hợp mạnh mẽ này cho phép bạn kết nối các mô hình cục bộ với các quy trình công việc thực tế và tự động hóa các tác vụ một cách hiệu quả.

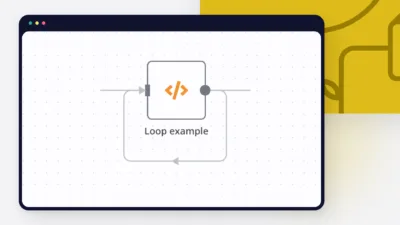

Bằng cách kết hợp tính linh hoạt của các LLM mã nguồn mở với khả năng tự động hóa của n8n, bạn có thể xây dựng các ứng dụng AI tùy chỉnh vừa mạnh mẽ vừa hiệu quả. LangChain (phiên bản JavaScript) là framework chính để xây dựng các tác nhân AI và các quy trình công việc dựa trên LLM trong n8n. Các khả năng tùy chỉnh và đổi mới gần như là vô hạn – bạn có thể sử dụng hàng trăm node đã được xây dựng sẵn hoặc viết các script JS tùy chỉnh.

Hãy cùng khám phá cách n8n giúp việc tạo ra các ứng dụng và quy trình công việc tùy chỉnh sử dụng LLM trở nên dễ dàng!

Có ít nhất 3 cách đơn giản để xây dựng dự án với các LLM mã nguồn mở trong n8n LangChain nodes:

- Chạy các mô hình nhỏ của Hugging Face với một User Access Token hoàn toàn miễn phí.

- Nếu bạn muốn chạy các mô hình lớn hơn hoặc cần phản hồi nhanh, hãy thử dịch vụ của Hugging Face gọi là Custom Inference Endpoints.

- Nếu bạn có đủ tài nguyên tính toán, hãy chạy mô hình qua Ollama cục bộ hoặc tự host.

Các node LangChain trong n8n + tích hợp Ollama giúp bạn dễ dàng truy cập các LLM mã nguồn mở và cung cấp cho bạn các công cụ hữu ích để làm việc với chúng. Đây là một video tổng quan về những khía cạnh quan trọng nhất:

Kết luận: cách dùng N8n Academy template để tích hợp các mô hình ngôn ngữ lớn (LLM)

Các bạn có thể tìm kiếm các template ứng dụng AI trong kho template của N8n tại đây