Tích hợp AI bằng N8n cho Doanh Nghiệp: Cần thận trọng

Hướng dẫn này nhằm cảnh báo các doanh nghiệp có mức độ rủi ro cao khi áp dụng N8n AI để duy trì cạnh tranh, nhưng hạn chế về bảo mật dữ liệu hoặc quyền riêng tư hay độ chính xác của thao tác. Nó trình bày các kỹ thuật như tối ưu độ chính xác của LLM, thiết lập giới hạn bảo vệ, chạy AI cục bộ trong công cụ tự động hóa, khả năng mở rộng và các yếu tố khác để nâng chuẩn AI doanh nghiệp.

Một số công cụ tự động hóa như n8n có thể tích hợp AI vào quy trình, giúp giảm thiểu rủi ro của các mô hình ngôn ngữ lớn, thị giác máy tính, và thuật toán AI khác.

Các yếu tố chính khi áp dụng AI vào doanh nghiệp

Khi các công cụ tự động hóa dựa trên workflow (luồng công việc) đóng vai trò như một lớp bao quanh các tác vụ AI như mô hình ngôn ngữ lớn (LLM), các tổ chức có thể giải quyết một số thách thức cấp thiết nhất liên quan đến AI, bao gồm:

- Đảm bảo dữ liệu đầy đủ và có tổ chức cho các Mô hình Ngôn ngữ Nhỏ (SLM) hoặc phản hồi theo ngữ cảnh – Các công cụ workflow có thể truy cập nhiều nguồn dữ liệu khác nhau và chuẩn hóa dữ liệu trước khi cung cấp cho mô hình AI để tạo phản hồi chính xác hơn..

- Bảo mật dữ liệu – Các mô hình AI có thể được chạy cục bộ hoặc tại một địa điểm đáng tin cậy. Các cơ chế bổ sung về bảo mật và ngăn ngừa rò rỉ dữ liệu cũng có thể được triển khai trước khi dữ liệu được gửi đến AI và sau khi phản hồi được tạo ra.

- Thiếu nhân lực và kỹ năng để tích hợp AI – Các công cụ tự động hóa dựa trên workflow cung cấp giao diện người dùng trực quan, giúp cả lập trình viên và người không chuyên có thể xây dựng logic tự động hóa tích hợp AI một cách dễ dàng.

- Giảm thiểu “ảo giác” của AI – Đây là hiện tượng AI tạo ra các phản hồi không chính xác hoặc vô nghĩa. Những phản hồi này cần được kiểm soát đầu ra để phát hiện lỗi hoặc nội dung không phù hợp.

Các loại mô hình AI và Machine Learning (ML)

Kể từ năm 2023, thuật ngữ AI thường được sử dụng thay thế cho mô hình ngôn ngữ lớn (LLM) và AI tạo sinh dựa trên văn bản, nhờ vào sự phổ biến bùng nổ của ChatGPT. Tuy nhiên, điều quan trọng là phải phân biệt rõ giữa các loại tác vụ AI sẵn sàng đưa vào sản xuất.

- AI tạo sinh (Generative AI) – Bao gồm các mô hình ngôn ngữ lớn và nhỏ, tạo ảnh, tạo video, và nhiều loại khác.

- Mô hình ngôn ngữ lớn (Large Language Models – LLM) – Là các mạng nơ-ron được huấn luyện trên lượng lớn dữ liệu văn bản, có khả năng hiểu ngữ cảnh, tạo ra văn bản giống con người, viết mã, và thực hiện các tác vụ suy luận phức tạp (ví dụ: GPT-4, Claude, PaLM). Ví dụ, bạn có thể tạo một hệ thống đa tác nhân để chuyển đổi file PDF thành nội dung blog.

- Mô hình ngôn ngữ nhỏ/đặc thù (Small/Specialized Language Models) – Được huấn luyện cho các tác vụ cụ thể như hoàn tất văn bản, phân tích cảm xúc, hoặc tạo nội dung theo lĩnh vực chuyên biệt, với số lượng tham số ít hơn nhiều so với LLM.

- Tạo ảnh bằng AI (Image Generation) – Là các mô hình có thể tạo ảnh mới từ mô tả văn bản hoặc chỉnh sửa ảnh hiện có (ví dụ: DALL·E, Midjourney, Stable Diffusion). Đây là một ví dụ về việc sử dụng AI để tạo ảnh.

- Tạo video bằng AI (Video Generation) – Hệ thống AI có thể tạo hoặc chỉnh sửa nội dung video từ văn bản hoặc cảnh quay có sẵn (ví dụ: Runway Gen-2, Google Imagen Video, Make-A-Video của Meta).

- Tạo giọng nói (Speech Generation) – Là mô hình chuyển đổi văn bản thành âm thanh, như quy trình sử dụng mô hình TTS của OpenAI.

- Thị giác máy tính (Computer Vision) – Dùng để phát hiện và nhận diện đối tượng trong ảnh/video, nhận diện và phân tích khuôn mặt. Ví dụ: tự động hóa quy trình kiểm tra hình ảnh với AI Vision.

- Nhận diện giọng nói (Speech Recognition) – Chuyển đổi âm thanh thành văn bản gần như theo thời gian thực, hỗ trợ nhiều ngôn ngữ.

- Phân tích chuỗi thời gian (Time Series Analysis) – Dùng để phân tích và dự đoán xu hướng, phát hiện các mô hình theo mùa, nhận diện bất thường và đưa ra dự đoán dựa trên dữ liệu phụ thuộc theo thời gian.

Dựa trên các công nghệ trên, một số ứng dụng AI sẵn sàng triển khai trong thực tế hiện nay bao gồm:

- Hỗ trợ khách hàng bằng chatbot và bot Slack

- Đặt lịch hẹn

- Tóm tắt và trò chuyện với tài liệu nội bộ (PDF)

- Thu thập dữ liệu web và tóm tắt nội dung trang

- Thêm bộ nhớ cho tác nhân AI

- Tự động hóa nghiên cứu đối thủ cạnh tranh

- Gán chú thích cho hình ảnh

- Giải quyết vấn đề hỗ trợ khách hàng bằng phân loại văn bản

Tối ưu hóa độ chính xác của mô hình ngôn ngữ lớn (LLM)

Trong số tất cả các mô hình AI hiện nay, mô hình ngôn ngữ lớn (LLM) có tiềm năng mang lại giá trị cao nhất cho doanh nghiệp trong ngắn hạn. Do đó, phần này sẽ tập trung vào việc tối ưu hóa LLM cho các trường hợp sử dụng cụ thể và chủ động giải quyết các thách thức liên quan đến hiện tượng “ảo giác” (hallucination).

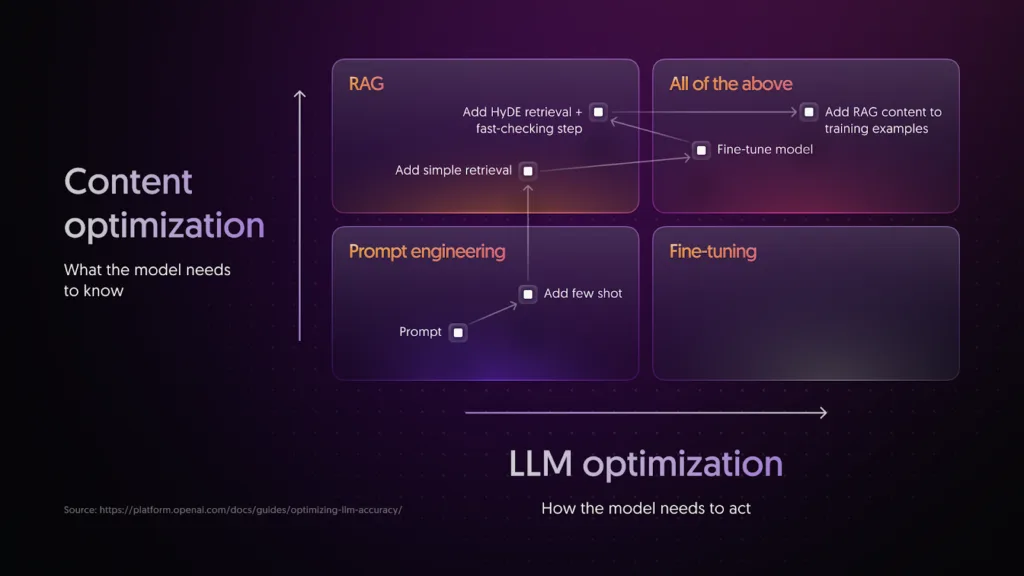

Việc tối ưu hóa LLM thường bao gồm các kỹ thuật:

- Prompt Engineering (Thiết kế câu lệnh đầu vào),

- RAG – Retrieval-Augmented Generation (Kết hợp truy xuất dữ liệu với việc tạo nội dung),

- Fine-tuning (Huấn luyện tinh chỉnh mô hình).

Ba kỹ thuật này phục vụ cho các mục tiêu tối ưu khác nhau và thường được sử dụng kết hợp để đạt hiệu quả cao nhất. Ngoài ra, chúng ta cũng cần triển khai các cơ chế bảo vệ (guardrails) để ngăn chặn các vấn đề như prompt injection (tiêm nội dung đầu vào độc hại) và rò rỉ dữ liệu.

Nguồn: Hướng dẫn từ OpenAI

Trong đồ họa phía trên của N8n, thuật ngữ “tối ưu hóa ngữ cảnh (context optimization)” ám chỉ việc mô hình thiếu kiến thức ngữ cảnh khi:

- Dữ liệu liên quan không có trong tập huấn luyện,

- Kiến thức của mô hình đã lỗi thời,

- Hoặc khi yêu cầu mô hình sử dụng thông tin độc quyền hoặc nội bộ.

Còn tối ưu hóa LLM đề cập đến việc đảm bảo tính nhất quán trong hành vi của mô hình. Việc tối ưu này cần được cân nhắc nếu mô hình, dù được cung cấp prompt phù hợp, lại:

- Tạo ra kết quả không nhất quán,

- Định dạng sai,

- Sai tông giọng hoặc văn phong,

- Và không tuân thủ các quy trình suy luận một cách logic.

Kỹ thuật thiết kế Prompt (Prompt Engineering)

Prompt engineering là kỹ thuật điều chỉnh câu lệnh đầu vào gửi đến mô hình ngôn ngữ lớn (LLM). Đây thường là phương pháp duy nhất cần thiết cho các trường hợp sử dụng như tóm tắt văn bản, dịch thuật và tạo mã, nơi phương pháp zero-shot (không cần huấn luyện thêm) vẫn có thể đạt được độ chính xác và tính nhất quán ở môi trường production kể cả khi dùng trong N8n.

🛠️ Các kỹ thuật cơ bản bao gồm:

- Điều chỉnh prompt để phù hợp với kết quả mong muốn.

- Bắt đầu với một prompt đơn giản và kết quả mong muốn, sau đó tối ưu hóa bằng cách thêm ngữ cảnh, hướng dẫn hoặc ví dụ.

🔗 Gợi ý: Bạn nên tham khảo Hướng dẫn Prompt Engineering của OpenAI.

Một số chiến lược từ hướng dẫn:

- Cung cấp văn bản tham chiếu (reference text).

- Chia nhỏ tác vụ phức tạp thành nhiều bước đơn giản.

- Cho mô hình thời gian để “suy nghĩ”.

- Sử dụng công cụ bên ngoài hỗ trợ.

- Thử nghiệm thay đổi một cách hệ thống.

Ngoài OpenAI, bạn cũng có thể tham khảo các hướng dẫn từ Anthropic và Mistral

🔧 Fine-Tuning – Huấn luyện tinh chỉnh mô hình

Fine-tuning là quá trình tiếp tục huấn luyện mô hình LLM với tập dữ liệu nhỏ, chuyên biệt để tối ưu hóa cho một nhiệm vụ cụ thể.

Tác dụng:

- Tăng độ chính xác của mô hình với nhiệm vụ đã định.

- Tối ưu hiệu suất, giảm số token cần thiết hoặc sử dụng mô hình nhỏ hơn vẫn đạt hiệu quả tương đương.

🎯 Bước quan trọng nhất trong fine-tuning là chuẩn bị tập dữ liệu huấn luyện:

- Dữ liệu phải sạch, có gán nhãn và không thiên lệch.

Mô hình triển khai cho Tự động hóa quy trình làm việc tăng cường AI

Hiện nay có hai lựa chọn để triển khai mô hình AI trong nền tảng tự động hóa quy trình:

- Tích hợp AI trực tiếp trong công cụ tự động hóa

- Chạy mô hình AI độc lập và gửi yêu cầu qua mạng

🤖 AI được tích hợp trực tiếp trong công cụ tự động hóa quy trình

Ưu điểm:

- Không phụ thuộc vào dịch vụ AI bên ngoài

- Dữ liệu không rời khỏi hệ thống ⇒ đảm bảo quyền riêng tư

- Không có độ trễ do mạng

- Không tốn chi phí trên mỗi lần gọi mô hình

Nhược điểm:

- Cài đặt và cấu hình phức tạp hơn

- Khó thay đổi mô hình AI nếu cần

🌐 Mô hình AI độc lập (Standalone AI Model)

Ưu điểm:

- Thiết lập và cấu hình dễ dàng

- Lựa chọn mô hình AI đa dạng

Nhược điểm:

- Rủi ro rò rỉ dữ liệu khi dữ liệu rời khỏi công cụ tự động hóa

- Có độ trễ do mạng

- Phát sinh chi phí theo từng lần gọi API

⚙️ Mô hình triển khai: Self-hosted vs As-a-Service

| Triển khai | Tích hợp AI trong công cụ tự động hóa | Mô hình AI độc lập |

|---|---|---|

| Tự triển khai (Self-hosted) | Doanh nghiệp quản lý và vận hành toàn bộ nền tảng trong môi trường của họ (on-premises hoặc cloud) | Doanh nghiệp tự chạy mô hình LLM (ví dụ: Ollama) trong môi trường của mình |

| Dịch vụ (As-a-Service) | Nền tảng do nhà cung cấp vận hành trên Cloud | Mô hình LLM chạy trên Cloud, tích hợp qua các lệnh gọi API (ví dụ: ChatGPT) |

Trong số các mô hình trên, mô hình tự triển khai một công cụ tự động hóa quy trình có tích hợp sẵn AI là khá hiếm, nhưng rất tiềm năng. Mô hình này:

- Mang lại quyền kiểm soát cao nhất cho doanh nghiệp

- Bảo mật dữ liệu tối đa vì không cần gửi dữ liệu ra ngoài

- Phù hợp với tổ chức có yêu cầu bảo mật, tuân thủ và hiệu suất cao

Chúng ta sẽ tìm hiểu sâu hơn về mô hình đặc biệt này ở phần tiếp theo.

Tự triển khai công cụ Tự động hóa quy trình làm việc tích hợp AI

Mô hình này giúp doanh nghiệp kiểm soát nhiều hơn cách vận hành và quản lý mô hình AI, tuy nhiên đòi hỏi sự tham gia trực tiếp nhiều hơn so với việc chỉ gửi yêu cầu API tới ChatGPT. Một số khó khăn khi vận hành AI tại chỗ bao gồm:

- Lựa chọn mô hình AI phù hợp

- Cấu hình vector store và framework

- Đảm bảo các thành phần hoạt động ăn khớp với nhau

Bộ khởi động AI tự lưu trữ của n8n

Để giảm bớt rào cản tiếp cận cao này, n8n đã phát hành AI Starter Kit tự lưu trữ từ tháng 8/2024. Bộ kit này là một template mã nguồn mở sử dụng Docker Compose, giúp khởi tạo một môi trường phát triển AI tại chỗ với nền tảng low-code.

Thành phần chính của Starter Kit:

- n8n – nền tảng tự động hóa quy trình

- Ollama – API để tương tác với các mô hình ngôn ngữ tại chỗ

- Qdrant – cơ sở dữ liệu vector

- PostgreSQL – cơ sở dữ liệu quan hệ

- Các mẫu workflow AI được cấu hình sẵn

Khả năng triển khai:

- Có thể chạy tại chỗ (on-premises) hoặc trên các dịch vụ đám mây do khách hàng quản lý như DigitalOcean, runpod.io

- Hỗ trợ truy cập file cục bộ thông qua thư mục chia sẻ được gắn kết vào container n8n

🤖 Tích hợp AI vào quy trình tự động hóa

Các workflow tích hợp AI thường xoay quanh các khả năng của mô hình AI như:

- Hiểu lệnh ngôn ngữ tự nhiên

- Nhận diện và phân loại đối tượng

- Phân tích dữ liệu phi cấu trúc

Cấu trúc workflow AI thường có:

- Logic trước khi gọi mô hình AI: xác định điều kiện khởi chạy, thu thập dữ liệu

- Logic sau khi gọi mô hình AI: xác thực kết quả, ngăn rò rỉ dữ liệu

📚 Đánh giá công cụ tự động hóa AI: hai yếu tố quan trọng

1. Workflow sẵn có

Nhà cung cấp nên cung cấp một thư viện các workflow AI:

- Được cấu hình và kiểm tra trước

- Dễ dàng triển khai, tùy biến

- Tài liệu đầy đủ

- Có thể do nhà cung cấp hoặc cộng đồng phát triển

Ví dụ: n8n hiện có thư viện hơn 160 workflow AI miễn phí.

2. Trình thiết kế Workflow

Để người dùng có thể tạo workflow AI tùy chỉnh, nhà cung cấp cần:

- Tài liệu chi tiết cách tích hợp AI trong logic tự động hóa

- Môi trường phát triển và kiểm thử (staging)

- Công cụ kiểm tra cấu hình và bảo mật, như:

- Dữ liệu không đúng định dạng

- Gọi dịch vụ bên ngoài không bảo mật

🚦 Vận hành công cụ Workflow AI trong môi trường sản xuất

Khi các workflow AI đã sẵn sàng, cần cân nhắc các yếu tố khi đưa vào chạy thực tế:

- Inference engine: hiệu năng của mô hình khi đưa vào sử dụng

- Khả năng mở rộng: đáp ứng khối lượng công việc tăng cao

- Giám sát và khắc phục lỗi: theo dõi trạng thái, ghi log, cảnh báo

- Phân quyền và bảo mật truy cập

Khả năng mở rộng (Scalability)

Khi triển khai workflow tự động hóa có tích hợp AI, khả năng mở rộng cần được xem xét ở cả mô hình AI lẫn công cụ tự động hóa.

1. Mở rộng động (Dynamic scaling):

- Trong môi trường cloud, hệ thống có thể tự động cấp phát tài nguyên.

- Trong môi trường tự lưu trữ (self-hosted), doanh nghiệp cần tăng số lượng instance theo chiều ngang (horizontal scaling) để xử lý lượng dữ liệu tăng lên, với ít gián đoạn nhất có thể.

2. Giới hạn tuyệt đối (Absolute scale limits):

- Số lượng workflow đồng thời

- Kích thước file tối đa

- Số lượng hành động tối đa trong một playbook

3. Hỗ trợ kỹ thuật:

- Các nhà cung cấp nhỏ dù có sản phẩm mở rộng tốt, nhưng có thể thiếu:

- Hỗ trợ kỹ thuật doanh nghiệp

- Quản lý sự cố

- Đối tác bên thứ ba hỗ trợ triển khai quy mô lớn

4. Giá thành:

- Một số mô hình giá của nhà cung cấp có thể giới hạn quy mô triển khai, khiến doanh nghiệp phải giảm loại dữ liệu thu thập, lưu trữ hoặc phân tích.

📈 Khả năng mở rộng của mô hình AI

Nếu sử dụng mô hình AI chạy trên cloud (ví dụ: ChatGPT):

- Chi phí là mối quan tâm lớn nhất, đặc biệt khi số lượng request tăng cao → chi phí vượt hiệu quả mong đợi.

Nếu sử dụng mô hình AI tự lưu trữ (self-hosted):

Yếu tố cần quan tâm:

- Khối lượng dữ liệu đầu vào tối đa

- Kết quả đầu ra tối đa

- Tỷ lệ lỗi

- Thời gian phản hồi trung bình (inference time)

Hạ tầng tính toán là yếu tố cốt lõi:

- Phải có đủ tài nguyên xử lý để đảm bảo hiệu suất

- Mô hình càng lớn, yêu cầu phần cứng càng mạnh

| Kích thước mô hình | Yêu cầu phần cứng |

|---|---|

| 1 – 3B tham số | Máy phổ thông |

| 30 – 70B tham số | Cần cụm GPU mạnh (VD: NVIDIA A100 x2) |

Thời gian phản hồi:

- Mô hình nhỏ: 100–500ms

- Mô hình lớn: 1–5 giây

- Có thể tối ưu với các kỹ thuật như:

- Quantization

- Distributed Inference

- Batch processing

- Caching thông minh

- Tăng tốc phần cứng (GPU, TPU)

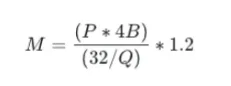

🧠 Yêu cầu GPU khi tự triển khai mô hình LLM

Công thức tính RAM GPU cần thiết:

Trong đó:

Giải thích các biến số:

| Biến | Ý nghĩa |

|---|---|

M | GPU memory cần thiết (tính bằng GB) |

P | Số lượng tham số của mô hình (số nguyên – ví dụ: 70 tỷ = 70,000,000,000) |

4B | Mỗi tham số chiếm 4 byte nếu dùng định dạng float32 |

32 | 32 bits = 4 bytes nếu dùng float32 |

Q | Số bit sử dụng cho mỗi tham số (ví dụ: 32, 16, 8) |

1.2 | Hệ số overhead ~ 20%, để dự phòng thêm dung lượng (caching, runtime, v.v.) |

Sử dụng AI trong doanh nghiệp bằng N8n ngay bây giờ

Đã có nhiều doanh nghiệp tích hợp AI vào mô hình hoạt động của mình, từ đó tạo nên những ưu thế cạnh tranh vượt trội. Doanh nghiệp của bạn cũng nên nhanh chóng bắt kịp xu thế và ứng dụng. 1 trong các cách nhanh mà tốn ít chi phí nhất là sử dụng N8n cho các công việc cần tích hợp AI.

Hãy tìm cho doanh nghiệp mình 1 template phù hợp để vận hành tại đây hoặc nhờ đội ngũ chuyên gia của chúng tôi hỗ trợ. Về chi phí chúng tôi tin răng không giải pháp nào rẻ mà lại có độ hiệu quả tương đương